Plans de suivi en temps réel et d’intervention : Élaborer des procédures

Summary

Lorsqu’un changement imprévu survient dans le cadre d’une étude portant sur un programme ou une politique sociale, le temps disponible pour y remédier est souvent limité. Des plans de suivi systématique peuvent donner aux chercheurs et au personnel du programme les moyens nécessaires pour repérer ce type de changement et effectuer les ajustements nécessaires en temps réel si certains aspects de l’étude s’écartent du projet initial.

Points essentiels à retenir

- Le suivi en temps réel vous permet d’être averti des problèmes qui nécessitent votre attention. Si vous n’avez connaissance d’aucun problème, c’est peut-être le signe que vous manquez d’informations !

- Parmi les indicateurs clés à surveiller dans le cadre d’une évaluation aléatoire, on peut notamment citer le respect des procédures de randomisation, le taux de participation et les indicateurs de qualité des données.

- Les systèmes automatisés de suivi et de signalement des problèmes peuvent être utiles, mais seulement si une personne est désignée pour contrôler attentivement les données qu’ils génèrent.

- Rien ne peut remplacer des interactions fréquentes avec le partenaire de mise en œuvre. Des visites ou des appels réguliers peuvent vous permettre de détecter les problèmes dès qu’ils surviennent.

Là où d’autres ressources consacrées au suivi de la mise en œuvre abordent la procédure globale de suivi et de documentation de l’étude (par exemple les entretiens avec le personnel et les procédures de back-checks réguliers et détaillés), la présente ressource offre un guide plus spécifique pour élaborer des plans d’action basés sur des indicateurs clés permettant de signaler tout changement et source d’inquiétude.

Introduction

Une bonne procédure de suivi doit permettre aux chercheurs de repérer toute déviation majeure par rapport au plan d’origine en observant les indicateurs de fonctionnement de l’intervention, de la collecte de données et des autres procédures essentielles (par exemple, le transfert de données ou le recueil du consentement éclairé). Les chercheurs doivent identifier un petit nombre d’indicateurs indispensables et déterminer comment en assurer le suivi. Ces activités de suivi doivent se poursuivre tout au long des phases de conception, de pilotage et de mise en œuvre de l’évaluation aléatoire. Cette ressource aide les lecteurs à :

- identifier les indicateurs qu’il est essentiel d’inclure dans la procédure de suivi en temps réel,

- faire le tri parmi les données entrantes grâce à la mise en place de contrôles et d’alertes générés automatiquement, et

- mettre en place des canaux de communication et des procédures pour l’examen des données de suivi et le signalement des problèmes.

Sélectionner les indicateurs et les données

Indicateurs

Choisir un ensemble restreint d’indicateurs1 permet de faire le tri dans la masse d’informations disponibles et d’alerter l’équipe de recherche en cas de changement ou de problème.

Les indicateurs clés à surveiller et à contrôler en temps réel peuvent concerner la qualité des données (par exemple le taux d’appariement lorsqu’on apparie plusieurs ensembles de données), le respect de la procédure de randomisation ou le taux de recrutement. Parmi les exemples d’indicateurs clés, on peut notamment citer la « durée de chaque séance de tutorat » comme indicateur de fidélité de la mise en œuvre d’un programme de tutorat ; ou, dans le cas d’une intervention dans le domaine de la santé, le « nombre de déviations par rapport au script de l’enquête », mesuré dans le cadre d’un contrôle aléatoire hebdomadaire des fichiers audio des enquêtes téléphoniques, comme indicateur de la pertinence du script ou du degré de compréhension des protocoles par le personnel.

En faisant preuve de sélectivité dans le choix des indicateurs clés, les chercheurs peuvent identifier rapidement les tendances importantes et les signaux d’alerte. En tenant compte de votre budget et de vos contraintes en matière de ressources, appuyez-vous sur vos questions de recherche pour identifier les éléments clés de l’étude qui doivent faire l’objet d’un suivi attentif. Voici quelques considérations qui peuvent vous aider à sélectionner les indicateurs pour la mise en place de votre plan de suivi et d’intervention rapide :

- Appuyez-vous sur vos questions de recherche et vos contraintes pratiques pour déterminer quels indicateurs inclure dans votre plan de suivi en temps réel, et à quelle fréquence les contrôler. Tenez compte de la gravité relative des problèmes potentiels, du budget disponible et des capacités du personnel pour sélectionner les indicateurs qui doivent faire l’objet d’un suivi attentif et la fréquence des contrôles.

- Identifiez les moments de l’étude où il est essentiel de contrôler les protocoles (en d’autres termes, les moments où vous craignez le plus que les choses tournent mal) et discutez-en à l’avance avec les parties prenantes. Les chercheurs et les responsables de la mise en œuvre doivent discuter ensemble (1) des problèmes survenus dans les précédentes versions de l’intervention et (2) des changements éventuellement apportés à l’intervention dans le cadre de l’étude. Soyez particulièrement attentifs à ces points dans vos futurs échanges.

- Évaluez le système existant avant le début de l’étude. Mesurez les valeurs de référence en matière de mise en œuvre qui serviront de points de repère pour les comparaisons ultérieures.

Sources et collecte de données

Identifiez les données qui sont disponibles pour rendre compte des indicateurs clés et déterminez comment recueillir les informations dont vous avez besoin. Les sources de données de suivi peuvent notamment inclure des statistiques sommaires de données administratives envoyées aux chercheurs à intervalles réguliers, les réponses à des enquêtes envoyées automatiquement aux chercheurs depuis des appareils électroniques, ou des données qualitatives échangées dans le cadre des appels de l’équipe.

Voyez s’il est possible de faire en sorte que les procédures de suivi et d’examen de la collecte de données soient les mêmes pour le groupe de traitement et le groupe témoin (de façon à préserver votre capacité à imputer les différences au traitement lui-même) ou si elles doivent être différentes en raison de contraintes pratiques (Glennerster et Takavarasha 2013, 306). Les méthodes de suivi elles-mêmes peuvent avoir une incidence sur l’impact d’une intervention ou d’une politique. Par exemple, si un plan de suivi prévoit notamment d’interroger les individus sur les traitements médicaux qu’ils reçoivent ou non, cela peut les inciter à consulter pour obtenir un traitement donné (Glennerster et Takavarasha 2013, 306). Pour évaluer ces possibilités, l’équipe de recherche peut effectuer des visites sur le terrain, contrôler les données et échanger avec les partenaires.

Selon les systèmes de données dont disposent les partenaires de mise en œuvre, il peut être intéressant tant pour l’équipe de recherche que pour les partenaires de collaborer à la mise à jour de ces systèmes et des procédures de collecte de données afin de favoriser la cohérence de la mise en œuvre et du suivi

Créer des tableaux et des rapports de suivi

Les tableaux de suivi présentent généralement un petit nombre d’indicateurs tels que l’intensité du traitement (le cas échéant) et l’équilibre des indicateurs entre le(s) groupe(s) de traitement et le groupe témoin (voir l’exemple de tableau de suivi disponible en annexe). Toute déviation dépassant les seuils de variation prévus peut inciter les chercheurs à procéder à un examen plus approfondi. Les tableaux et les rapports doivent servir de complément à des échanges libres et transparents avec les partenaires et au sein de l’équipe de recherche.

Mettre en place des seuils et des alertes automatiques

Intégrez des alertes dans vos tableaux de suivi et mettez en place des procédures pour donner les moyens au personnel de mise en œuvre et de recherche de signaler les problèmes éventuels, même s’ils ne sont pas sûrs de ce qui se passe. Les signaux d’alerte automatiques doivent amener l’agent responsable du suivi à faire remonter ses inquiétudes à la partie concernée. Par exemple, “si la variable A passe en dessous d’un certain seuil, il faut alerter le chercheur principal” ; “si la variable B augmente rapidement, il faut en parler au partenaire de mise en œuvre”. Il est également important de mettre en place des mécanismes pour permettre au personnel d’exprimer des inquiétudes sur la base d’informations qui ne dépassent pas les seuils de notification prédéfinis, mais qui suscitent néanmoins des doutes quant au bon déroulement des opérations.

Les tests d’équilibrage permettent de vérifier que la randomisation fonctionne conformément aux attentes en recherchant des différences entre les caractéristiques observables du groupe de traitement et du groupe témoin. Les contrôles à haute fréquence peuvent être un moyen utile d’optimiser les procédures de contrôle et de signalement automatiques. Innovations for Poverty Action (IPA) a développé des lignes de code Stata pour les contrôles à haute fréquence, spécialement conçues pour les enquêtes en population et les évaluations aléatoires. Ces lignes de code permettent d’exécuter des contrôles à haute fréquence sur les données de recherche entrantes.

Facteurs à prendre en compte lors de la création des tableaux de suivi

Randomisation : Pour les études dont la randomisation est effectuée au fil de l’eau ou sur place, les tableaux de suivi doivent contrôler automatiquement l’équilibre des variables clés ou des taux d’inscription entre le(s) groupe(s) de traitement et le groupe témoin.2 Si le déséquilibre dépasse les seuils prévus, l’équipe de recherche doit examiner les causes possibles de ce déséquilibre, qu’il s’agisse de déviations délibérées ou involontaires par rapport à la procédure de randomisation.

Prenons l’exemple d’une intervention d’aide intensive à la recherche d’emploi dans le cadre de laquelle les jours d’intervention sont randomisés, avec un calendrier de randomisation établi plusieurs semaines à l’avance et communiqué au personnel du centre d’aide à la recherche d’emploi. Si le nombre de demandeurs d’emploi qui se présentent au centre est beaucoup plus élevé les jours de traitement, les chercheurs peuvent échanger avec le personnel afin d’en déterminer la raison. Le personnel peut notamment vérifier que le calendrier de randomisation n’a pas été affiché par mégarde à un endroit où il est visible par les demandeurs d’emploi, ou déterminer si ce sont les demandeurs d’emploi qui recommandent les services à leurs amis qui se présentent le jour même (ce qui peut être l’un des résultats souhaités de l’intervention), ou si d’autres facteurs entrent en ligne de compte.

Participation : Suivez les indicateurs relatifs au nombre d’individus ou de groupes assignés au traitement qui choisissent de participer à l’intervention et à l’intensité de leur participation. Par exemple, si une intervention nécessite que les participants assistent à des formations ou à d’autres séances, il est important de contrôler le taux d’assiduité au fil du temps. Si le taux de participation est inférieur aux prévisions, cela peut avoir des conséquences sur la puissance statistique et être révélateur de l’existence de déviations par rapport aux protocoles d’origine de l’étude ou de l’intervention proprement dite.

Technologie : Les tableaux de suivi peuvent faciliter la détection des problèmes imprévus provoqués par le code, le matériel informatique ou tout autre outil technologique. Si une étude est fortement tributaire de certaines technologies (par exemple, les tablettes pour l’administration des enquêtes), les chercheurs doivent mettre au point un dispositif pour en contrôler la fonctionnalité. Dans le cas d’une étude dont les enquêtes sont réalisées sur tablette, on peut ainsi inclure dans les tableaux de suivi des indicateurs codés en dur, comme le pourcentage des enquêtes entamées qui ont été menées à bien, tout en établissant des canaux de communication pour demander régulièrement aux enquêteurs s’ils rencontrent des difficultés avec les tablettes.

Même avec un plan de suivi élaboré avec soin, il peut arriver que des problèmes passent inaperçus. Par exemple, si la logique du code ou de l'algorithme d’une intervention basée sur la technologie est modifiée dans le cadre d’une mise à jour logicielle sans rapport avec l’étude, cela risque d’affecter l’assignation aléatoire et le traitement.3 En procédant au suivi de la première étape, et en mettant en place des canaux permettant une communication libre et régulière, les chercheurs et les responsables de la mise en œuvre ont plus de chances de prévenir et de détecter ce type de problèmes.

Étude de cas : Des modifications ou des erreurs non détectées dans le code risquent de compromettre la fidélité du traitement. Dans le cadre d’une étude, des prestataires de soins de santé avaient été désignés aléatoirement soit pour recevoir une notification pop-up d’incitation par l’intermédiaire d’un logiciel de dossier médical électronique (traitement), soit pour continuer à travailler comme avant (témoin). Au milieu de l’étude, une modification non détectée du logiciel de l’intervention a changé les critères d’inclusion qui déterminaient le moment où l’alerte apparaissait, suite à quoi les prestataires du groupe témoin se sont mis à recevoir l’alerte normalement réservée au groupe de traitement. Ce changement s’est produit plusieurs mois après le début de l’étude et les chercheurs ne l’ont découvert qu’une fois la collecte de données terminée. L’équipe de recherche a tout de même pu utiliser les données, mais pour répondre à une question de recherche différente de celle qui était initialement prévue.

Une procédure de contrôle et de suivi bien exécutée aurait peut-être permis de signaler cette erreur aux chercheurs dès son apparition. Dès lors que c’est possible, il est important de mettre en place un plan de suivi permettant de contrôler l’intensité du traitement (par exemple, l’envoi des notifications à la fois au groupe de traitement et au groupe témoin) pour signaler automatiquement les sources d’inquiétude (dans cet exemple, en avertissant les chercheurs si un membre du groupe témoin reçoit une notification d’incitation). Ce type d’alerte facilite la communication entre les chercheurs et le personnel des organismes de mise en œuvre. La combinaison de ces différents systèmes peut permettre de détecter ou d’éviter des changements aux effets imprévus.

Mettre en place des procédures de communication, d’examen des données et de signalement des problèmes

L’équipe de recherche doit établir un plan pour passer en revue les tableaux de suivi et répondre aux problèmes détectés. Les mesures ci-dessous peuvent l’aider à exploiter au mieux les tableaux de suivi et les autres sources d’information.

Désigner un responsable principal du suivi

Désignez une personne qui sera spécialement chargée de contrôler les quelques indicateurs essentiels des tableaux de suivi à des intervalles réguliers, raisonnables et clairement définis. En examinant régulièrement les tableaux, la personne ainsi désignée sera en mesure de détecter et de signaler tout changement majeur, toute anomalie ou tout autre signal d’alarme concernant la mise en œuvre de l’intervention. Il est essentiel de mettre en place des plans détaillés pour le contrôle et la prise en compte des données de suivi : en l’absence de procédures adaptées et réalisables, les tableaux de suivi risquent d’être négligés et donc de s’avérer inefficaces. Un plan efficace doit permettre d’identifier les principales sources d’inquiétude et doit s’articuler raisonnablement avec les autres responsabilités du personnel concerné.

Réduire les obstacles qui freinent la remontée des inquiétudes

Bien qu’il soit impossible de spécifier à l’avance comment répondre à toutes les situations possibles, il peut être utile de fixer quelques seuils importants (voir ci-dessus) et de mettre en place des procédures permettant de réagir rapidement en cas de problème. Ce point est particulièrement important si ce sont des membres du personnel moins expérimentés, comme les assistants de recherche, qui sont chargés d’examiner les données et de faire le tri parmi les problèmes : le personnel doit se sentir autorisé à solliciter l’avis du reste de l’équipe. La mise en place de procédures préétablies, associées à des conversations régulières avec les chefs de projet, peuvent aider les assistants de recherche à identifier ce qui doit être signalé et immédiatement notifié, ce qui doit être signalé sans pour autant être urgent, et ce qui doit être documenté mais ne risque pas de poser de problème à terme. Des plans bien définis et des canaux de communication ouverts permettent au personnel de travailler en étroite collaboration pour prendre des décisions éclairées.

De même, les partenaires de mise en œuvre doivent se sentir libres de faire part de leurs préoccupations concernant les protocoles, qu’ils aient constaté des modifications du protocole dans la pratique, qu’ils pensent que le protocole devrait être modifié, ou les deux. Si possible, discutez à l’avance de la manière dont vous envisagez d’annoncer et de concevoir les changements potentiels à apporter aux protocoles de mise en œuvre si l’intervention venait à évoluer au fil du temps.

Étude de cas : Dans le cadre d’une intervention de gestion des cas conçue pour aider les étudiants à faible revenu à surmonter les obstacles qui les empêchent de terminer leurs études, les chercheurs ont observé que les différences de résultats entre le groupe de traitement et le groupe témoin se réduisaient au bout de deux ans (Evans et al. 2017). Les variables de résultat incluaient l’inscription à l’université, la moyenne générale et l’obtention d’un diplôme. Au bout d’un an, les résultats du groupe témoin ont commencé à se rapprocher de ceux du groupe de traitement. En réponse à ce type d’évolution, les chercheurs peuvent demander à discuter de ces changements avec le personnel du programme. Ces conversations ne doivent pas être présentées comme un constat d'échec du programme, mais plutôt comme une invitation à examiner ensemble le programme afin de comprendre ce qui a changé.

Dans cet exemple, l’équipe chargée de l’étude a lu les notes de cas et a constaté qu’une diminution des échanges entre les étudiants et les conseillers au fil du temps était l’une des causes possibles de la réduction de l’écart entre les résultats du groupe de traitement et ceux du groupe témoin. Ils ont constaté que le temps moyen que les conseillers consacraient à chaque entretien avec les étudiants avait diminué à partir de la fin de la première année. Cette baisse n’était pas conforme aux directives du programme et a réduit l’effet de l’intervention.

Afin d’ajuster l’intervention pour qu’elle corresponde à la mise en œuvre souhaitée, le personnel du programme a modifié les recommandations et les exigences à l’intention des conseillers en leur demandant de veiller à ce que chaque séance respecte une durée minimale spécifique. Un plan de suivi qui signale toute réduction de l’écart entre les résultats du groupe de traitement et du groupe témoin, ainsi qu’une communication réfléchie entre les chercheurs et les partenaires de mise en œuvre, peuvent favoriser ce type d’investigation et d’ajustement

Organiser des appels et des visites réguliers avec les partenaires de mise en œuvre

Les partenaires de mise en œuvre détiennent des informations essentielles sur l’avancement de l’étude, ainsi que sur les changements ou problèmes pouvant survenir dans le cadre de l’intervention ou de l’étude. Lors du processus de sélection des indicateurs et des données, mais aussi tout au long des phases de conception et de mise en œuvre de l’étude, il est important que l’équipe de recherche et le personnel de mise en œuvre organisent des appels réguliers afin de faire le point sur les évolutions récentes et d’évoquer les problèmes éventuels.

Organiser des appels réguliers avec le personnel concerné pour discuter des détails de l’étude, se tenir au courant des dernières nouvelles et suivre l’avancement des travaux en général, et ce même s’il semble peu probable qu’il y ait des problèmes, donne l’opportunité d’être informé des problèmes dès leur apparition.4 Ces points réguliers permettent de créer des habitudes et d’instaurer un climat de compréhension et de confiance mutuelles, ce qui sera utile en cas de problème. Cela permet également d’éviter que des problèmes mineurs ne s’aggravent. Un dialogue ouvert et régulier permet à l’équipe de mieux identifier des anomalies qui peuvent sembler mineures pour certains, mais qui sont en réalité des problèmes majeurs. Il n’est pas nécessaire d’avoir un ordre du jour pour chaque appel : le plus important est d’avoir des contacts réguliers.

Les visites sur le terrain, si elles sont possibles, sont un autre moyen de favoriser la communication avec les partenaires et d’observer directement la mise en pratique des protocoles.

Envisager de nommer un « assistant de recherche de terrain » ou d’installer un chercheur sur le terrain

Désigner un assistant de recherche pour assurer l’interface avec les partenaires de mise en œuvre sur le site de l’étude peut être un moyen précieux d’établir de bonnes relations de travail et de créer un canal de communication permettant à l’équipe de recherche d’être informée des problèmes imprévus dès qu’ils surviennent. On peut choisir de nommer un « assistant de recherche de terrain » chargé de travailler à plein temps sur ces tâches, ou d’intégrer les activités de terrain aux responsabilités d’un assistant de recherche qui effectue par ailleurs un travail de bureau plus classique centré sur les données. Cet assistant de recherche de terrain pourra être chargé à la fois d’assurer le suivi de la mise en œuvre et de vérifier si les protocoles prévus sont pertinents pour le partenaire ou s’ils doivent être modifiés.

Certains projets peuvent nécessiter la présence d’un assistant de recherche sur le terrain à temps plein, là où pour d’autres, le suivi sur le terrain peut se limiter à des visites moins fréquentes d’un assistant de recherche ayant des responsabilités à la fois en matière de données et de travail sur le terrain. Par exemple, envoyer un assistant de recherche effectuer une visite d’une journée sur un site de l’étude peut lui permettre d’observer en temps réel la façon dont les protocoles sont mis en œuvre. Si un calendrier de visites régulières est établi, il est important d’effectuer ces visites comme prévu, même si aucun problème n’a encore été détecté. En effet, ces visites peuvent contribuer à établir de bonnes relations et à renforcer les plans d’intervention en cas de problème ultérieur.

Annexe : Exemples de tableaux de suivi

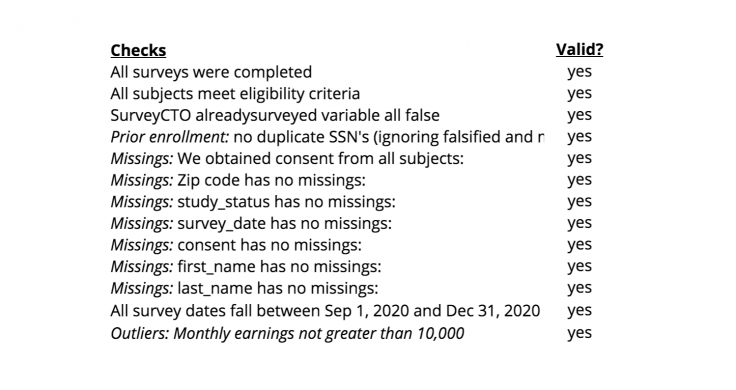

Annexe, Tableau A : Contrôles oui/non importants

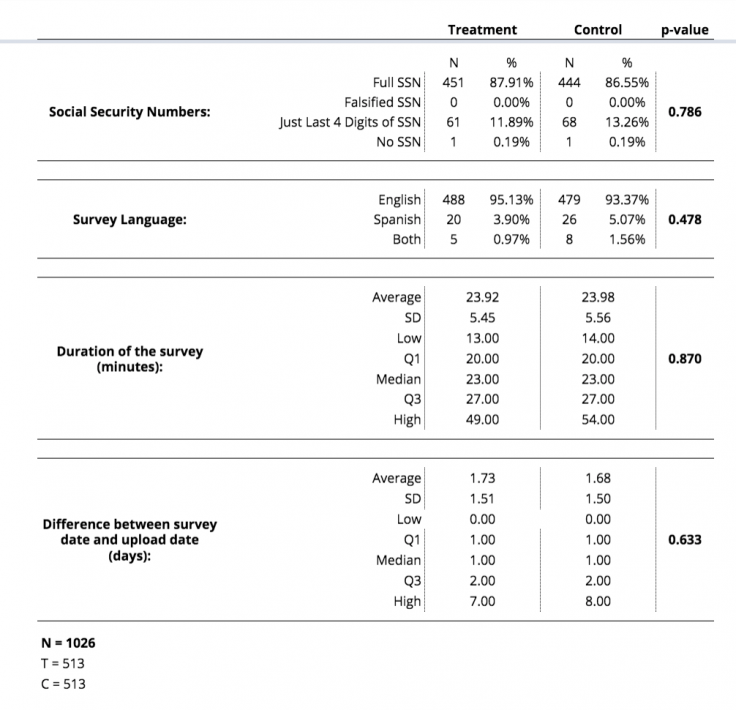

Annexe, Tableau B : Tests d’équilibrage sur mesure

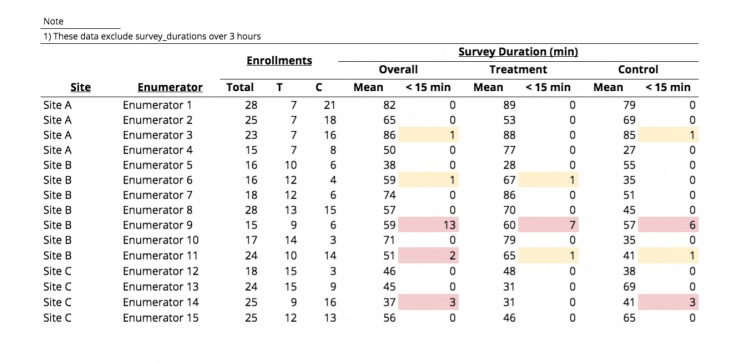

Annexe, Tableau C : Durée de l’étude

Par exemple, si une enquête est conçue pour durer 45 minutes, il peut être utile de comptabiliser le nombre d’enquêtes qui sont beaucoup plus courtes que prévu (dans ce cas, le seuil critique est fixé à 15 minutes). Même s’il peut arriver qu’une enquête soit plus courte, et même si une seule enquête courte n’est pas nécessairement un motif d’inquiétude, l’équipe de recherche peut décider qu’elle souhaite vérifier si les enquêteurs effectuent souvent des enquêtes d’une durée inférieure à 15 minutes. Dans le tableau ci-dessus, la présence d’une enquête courte est une simple « alerte jaune ». Cependant, si un enquêteur réalise au moins deux enquêtes de moins de 15 minutes au cours d’une période de suivi donnée, cela déclenche une « alerte rouge » qui peut conduire un membre de l’équipe de recherche à prendre contact avec l’enquêteur concerné pour lui demander s’il rencontre des difficultés.

Nous remercions Mike Gibson, Sam Ayers, Kim Gannon, Sarah Kopper et Sam Wang pour leurs conseils et leurs suggestions. Nous remercions Stephanie Lin d’avoir rassemblé des exemples concrets d’enseignements tirés de missions de recherche antérieures, qui ont servi de base aux études de cas mentionnées dans cette ressource. Ce document a été relu et corrigé par Caroline Garau, et traduit de l’anglais par Marion Beaujard. Le présent travail a pu être réalisé grâce au soutien d'Arnold Ventures et de la Fondation Alfred P. Sloan. Toute erreur est de notre fait.

Un « indicateur » est un signal observable (Glennerster and Takavarasha 2013, 181).

Pour des suggestions sur la documentation de la randomisation, consultez cette ressource sur la gestion des fichiers, des données et de la documentation pour les évaluations randomisées.

L'évaluation des interventions basées sur la technologie propose davantage d'exemples et de recommandations pour étudier les interventions qui peuvent être affectées par les mises à jour logicielles et les modifications de code.

Le guide de J-PAL North America intitulé « Implementing Randomized Evaluations in Government: Lessons from the J-PAL State and Local Innovation Initiative » partage des discussions et des exemples pour guider la communication avec les partenaires dans le cadre d’un plan de suivi (Chabrier et al., 2017, p. 20-22). Par exemple, il peut être utile de discuter avec les partenaires de la manière dont le suivi pendant une période pilote peut clarifier ou répondre à des questions importantes avant le début de l'étude. Dans une étude sur le programme Bridges to Success à Rochester, NY (un programme de mentorat visant à aider les résidents des quartiers à forte pauvreté de Rochester à surmonter les obstacles à l'autosuffisance), les chercheurs et les responsables ont mené une période pilote pour surveiller les taux d'inscription au programme. Comme les taux d'inscription étaient plus faibles que prévu, le programme a élargi ses critères d'éligibilité avant le lancement complet de l'étude afin de remplir les places disponibles dans le programme (Chabrier et al., 2017, p. 22-23).

Additional Resources

Évaluer les interventions basées sur la technologie, J-PAL Amérique du Nord. Cette ressource donne des conseils pour les évaluations qui portent sur une intervention où la technologie joue un rôle clé, et aborde les défis spécifiques auxquels le personnel de J-PAL Amérique du Nord a été confronté dans le cadre de ce type d’études. Ces exemples de difficultés pourront aider les lecteurs à anticiper la façon dont un plan de suivi peut permettre de détecter et de prévenir les défis liés à la technologie.

Formaliser le partenariat de recherche et définir les rôles et les attentes, J-PAL Amérique du Nord. Cette ressource décrit les démarches à suivre pour établir et développer une relation de travail solide avec le partenaire de mise en œuvre au début d’une évaluation aléatoire. Les sous-sections « Définir une stratégie de communication » et « Les composantes d’une stratégie de communication » peuvent éclairer la prise de décisions concernant la mise en place d’un dialogue régulier avec les partenaires dans le cadre d’un plan de suivi.

Contrôles à haute fréquence, Innovations for Poverty Action (IPA). Ces lignes de code Stata sont conçues pour les études basées sur des enquêtes en population et les évaluations aléatoires. Ce code permet d’exécuter des contrôles à haute fréquence sur les données de recherche entrantes. Ces exemples peuvent être personnalisés pour s’adapter aux besoins de l’étude.

Randomisation : Tests d’équilibrage et re-randomisation, J-PAL. Cette ressource met à disposition des exemples de code et des commandes permettant d’effectuer des tests d’équilibrage et d’autres procédures.

References

Chabrier, Julia, Todd Hall, and Ben Struhl. 2017. “Implementing Randomized Evaluations In Government: Lessons from the J-PAL State and Local Innovation Initiative.” J-PAL Amérique du Nord.

Evans, William N., Melissa S. Kearney, Brendan C. Perry, and James X. Sullivan. 2017. “Increasing Community College Completion Rates among Low-Income Students: Evidence from a Randomized Controlled Trial Evaluation of a Case Management Intervention.” NBER Working Paper. https://www.nber.org/papers/w24150

Glennerster, Rachel and Kudzai Takavarasha. 2013. Running Randomized Evaluations: A Practical Guide. Princeton: Princeton University Press.

J-PAL. 2019. Conférence sur le suivi de la mise en œuvre donnée dans le cadre de la formation 2019 pour le personnel de recherche.