Introduction to measurement and indicators

Summary

Les mesures visent à obtenir des données fiables permettant de répondre aux questions de recherche et d’évaluer la validité de la théorie du changement. Si ces mesures sont imprécises, elles risquent de produire des données peu fiables, sur la base desquelles il sera difficile de tirer des conclusions valables. Cette ressource aborde les concepts clés associés aux mesures, les différentes méthodes de collecte des données, les personnes auprès desquelles les données doivent être collectées et les sources les plus courantes d’erreur de mesure. La ressource suivante, consacrée à la conception des enquêtes, applique ces concepts à l’élaboration des questionnaires d’enquête. Consultez également notre répertoire de ressources sur les mesures et la conception des enquêtes, qui présentent aux lecteurs les différents outils de mesure ainsi que les difficultés potentielles et leurs solutions possibles dans un large éventail de domaines.

Principes fondamentaux

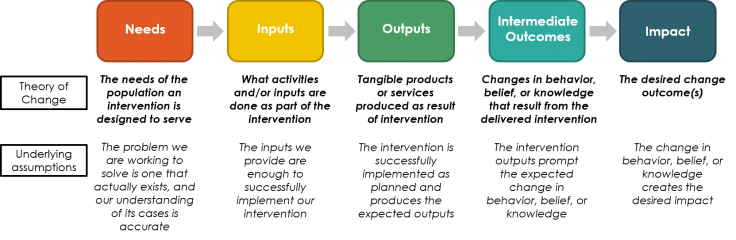

- Pour pouvoir tester votre théorie du changement, vous devez disposer de données sur les besoins, les intrants, les extrants, les résultats intermédiaires et l’impact.

- Il est également nécessaire de collecter des données sur les covariables (en particulier si vous pensez que les effets du traitement ont des chances d’être hétérogènes), les facteurs prédictifs de la conformité et les mesures de la conformité réelle au traitement. Il peut aussi être utile de recueillir des informations sur le contexte et le rapport coût-efficacité, ainsi que des informations qualitatives (le « pourquoi » et le « comment »).

- Il est possible d’utiliser des données secondaires (par exemple des données administratives ou des données de recensement) en complément voire en lieu et place de la collecte de données primaires. Si vous envisagez d’avoir recours à des données secondaires, réfléchissez bien à la manière dont vous allez intégrer les deux sources de données lors de la conception de votre enquête.

- Des problèmes de mesure peuvent survenir lorsque :

- Les concepts à mesurer sont vagues ou mal définis

- Les indicateurs ne constituent que des mesures imparfaites du concept sous-jacent

- Les réponses des répondants individuels sont faussées, que ce soit parce que le répondant est distrait, malade, ou encore parce qu’il a mal compris

- Des erreurs humaines ou techniques donnent lieu à des valeurs erronées

- Il existe de nombreux types d’erreur de mesure, que nous regroupons ici en trois grandes catégories :

- Les problèmes liés aux questions : Ils sont dus à une mauvaise formulation des questions. Ils peuvent être liés à la présence d’imprécisions, de négations, de questions doubles, de présupposés, de catégories qui se recoupent et d’effets de cadrage (au sein des questions individuelles et à l’échelle du questionnaire).

- Les problèmes liés aux réponses : Ils sont dus à la présence d’erreurs dans la construction des options de réponse proposées, et notamment à des catégories manquantes ou au fait que plusieurs catégories se recoupent.

- Les problèmes liés aux répondants : Ils sont dus aux biais intrinsèques du sujet qui répond aux questions, notamment le biais de mémoire, l’ancrage, la partialité, le biais de désirabilité sociale, le télescopage, le biais de déclaration et les biais de réponse différentielle.

- Les biais qui sont corrélés au traitement sont plus graves que ceux qui ne le sont pas.

Objectif et mise en pratique des mesures

Quelques décisions essentielles :

- Qu’avez-vous besoin de mesurer ?

- De quel type de données avez-vous besoin pour effectuer ces mesures ?

- Comment ces données doivent-elles être collectées ?

- Auprès de qui doivent-elles être collectées ?

Qu’avez-vous besoin de mesurer ?

Vous allez devoir recueillir des informations pour tester vos hypothèses à chaque étape de votre théorie du changement, des intrants jusqu’aux résultats finaux. Veillez à bien définir la feuille de route théorique de votre projet dans le contexte spécifique qui vous intéresse. Des données sont nécessaires chaque fois qu’il existe un risque de rupture dans l’enchaînement logique de votre théorie du changement.

En outre, il est souvent utile de collecter des données sur les éléments suivants :

- Les covariables : Si vous pensez que l’effet du traitement est susceptible de varier en fonction de certaines caractéristiques des participants ou du lieu de l’étude (sexe, milieu urbain ou rural, distance jusqu’à l’hôpital le plus proche, etc.), assurez-vous de collecter des données sur ces caractéristiques. Si vous souhaitez procéder à une stratification en fonction de certains critères, il est cependant recommandé de le décider le plus tôt possible afin d’être certain d’avoir la puissance nécessaire pour détecter des effets de traitement hétérogènes. Notez que cette décision aura une incidence sur d’autres aspects du processus de planification : si vous effectuez une stratification, il faudra en tenir compte dans vos calculs de puissance et l’élaboration de votre budget. Si vous rédigez un plan de pré-analyse, pensez à inclure les covariables utilisées pour la stratification. Voir Angelucci, Karlan et Zinman (2013) pour un exemple d’article mesurant des effets de traitement hétérogènes.

- Les facteurs prédictifs de la conformité et les mesures de la conformité réelle au traitement (au niveau de l’individu et du groupe) : Par exemple, dans le cas d’une intervention médicale nécessitant la prise de comprimés, il peut être utile de recueillir des informations au début de l’étude pour savoir si les répondants prennent actuellement des comprimés tous les jours et à quelle fréquence ils pensent à le faire, puis de nouveau en fin d’étude pour savoir à quelle fréquence ils ont pris leurs comprimés.

- Le contexte (pour la validité externe/généralisabilité) : Il peut notamment s’agir de l’exposition des participants à d’autres programmes similaires, de la proximité d’écoles ou d’hôpitaux, le cas échéant, etc. Cette question est traitée en détail dans la conférence intitulée « Measurement Outcomes, Impacts, and Indicators » de la formation sur l'Évaluation des programmes sociaux.

- Les coûts : Pour calculer le rapport coût-efficacité, il faut disposer de données complètes sur le coût de l’intervention elle-même, mais aussi sur le prix des alternatives potentielles, sur les économies réalisées et/ou les coûts supportés par les répondants du fait de l’intervention, etc. Pour plus d’informations, voir le guide de J-PAL sur le rapport coût-efficacité.

- Des informations qualitatives (le « pourquoi » et le « comment ») : Par exemple, si un répondant indique, dans le cadre de l’enquête de fin d’étude, que son enfant est allé plus régulièrement à l’école que par le passé, on peut lui poser une question complémentaire pour savoir quelle en est la raison principale.

La plupart des enquêtes sont bien trop longues, ce qui peut provoquer une certaine lassitude chez les personnes interrogées et, par conséquent, nuire à la qualité des données. Mesurez exactement ce dont vous avez besoin pour répondre à vos questions de recherche (ou à d’éventuelles questions de recherche futures), mais n’allez pas au-delà. Si vous ne savez pas exactement comment vous allez exploiter une question, ou si elle n’est pas directement liée à une question de recherche spécifique, ne l’incluez pas. Pour plus d’informations sur la conception des enquêtes, cliquez ici.

De quel type de données avez-vous besoin ?

Si vous utilisez des données primaires, c’est-à-dire des données que vous collectez vous-même, plusieurs décisions fondamentales restent encore à prendre :

- Les données proviennent-elles d’individus ou sont-elles générées automatiquement ?

- Les données collectées auprès d’individus peuvent être issues d’enquêtes, d’examens, de jeux, de « vignettes » (ou scénarios fictifs), d’observations directes, de journaux ou de registres, de groupes de discussion ou d’entretiens

- Les données générées automatiquement sont recueillies par le biais d’une machine ou d’un procédé, comme par exemple la température ou la vitesse du vent

- Allez-vous utiliser des enquêtes existantes ou de nouveaux instruments d’enquête ?

- S’inspirer d’enquêtes existantes ayant permis de mesurer efficacement les variables d’intérêt que vous ciblez permet de gagner du temps et d’économiser des ressources (dans la mesure où l’enquête a déjà été conçue, testée et utilisée), et limite le risque que votre instrument contienne des problèmes.

- Un nouvel instrument d’enquête peut être conçu de façon à être parfaitement adapté à vos besoins spécifiques. Cependant, élaborer et tester un tel instrument demande du temps. Pour en savoir plus, consultez la ressource sur la conception des enquêtes.

- Enquête transversale ou enquête de panel ?

- La plupart des ECR utilisent des données de panel, l’objectif étant de suivre le devenir des personnes qui ont reçu ou non un traitement donné. Cependant, il peut parfois être intéressant d’utiliser des données transversales si vous pensez qu’il y a de fortes chances que les participants modifient leur comportement du fait de leur participation à l’étude. Pour plus d’informations, voir la ressource sur le suivi de la mise en œuvre.

Les données secondaires peuvent être des données administratives (c’est-à-dire des dossiers conservés par les pouvoirs publics ou d’autres organismes pour des raisons administratives, tels que les naissances, les décès, les déclarations d’impôts, les résultats d’examens, etc.) ou des données non-administratives (c’est-à-dire des données recueillies à des fins de recherche ou à d’autres fins non-administratives). Si vous souhaitez utiliser des données secondaires, il est important de prendre en compte les éléments suivants :

- Les données existent-elles, et est-il possible d’y accéder ?

- Si elles ne sont pas accessibles, y a-t-il une procédure officielle pour en négocier ou en demander l’accès ?

- Quelle est la période de référence ? Les données ont-elles été collectées de façon systématique tout au long de cette période ?

- L’ensemble de données couvre-t-il la population cible ? Y a-t-il un risque que la couverture soit inégale ou biaisée ?

- L’ensemble de données couvre-t-il les variables d’intérêt ?

- L’ensemble de données est-il fiable et a-t-il peu de risques d’avoir été manipulé ?

Pour plus d’informations sur les données administratives, y compris dans quels cas et comment les utiliser, ainsi que sur les sources de biais potentielles, consultez les ressources intitulées Utiliser des données administratives dans le cadre d’une évaluation aléatoire et Évaluer les interventions basées sur la technologie. Le manuel IDEA publié par J-PAL contient des informations techniques très détaillées concernant l’accès aux données administratives, leur protection et leur utilisation. Certaines sources de données secondaires sont répertoriées à la fin de cette ressource.

Comment les données doivent-elles être collectées ?

Bien que les présentes ressources se concentrent essentiellement sur la collecte de données en vue d’une analyse quantitative, il existe également d’autres formes de collecte de données :

- Le recensement : En règle générale, l’enquête est effectuée auprès d’un échantillon de la population cible (la base d’échantillonnage). Pour obtenir un échantillon représentatif, il vous faudra extraire un échantillon de la population globale, soit en utilisant les données de recensement existantes, soit en collectant vos propres données.

- Les données qualitatives peuvent être utilisées pour orienter la conception de l’intervention, pour savoir comment se déroule la mise en œuvre, pour comprendre le contexte en matière de non-conformité ou d’attrition, et bien d’autres choses encore. Parmi les techniques de collecte de données qualitatives, on peut notamment citer les entretiens semi-directifs, les évaluations, les jeux, les observations et les groupes de discussion. Vous trouverez un exemple d’application des méthodes de recherche qualitative aux études sur le genre dans le Practical Guide to Measuring Girls’ and Women’s Empowerment in Impact Evaluations publié par J-PAL.

Auprès de qui les données doivent-elles être collectées ?

Le répondant cible :

- Doit être la personne la mieux informée au sujet de vos variables d’intérêt

- Peut varier d’un module à l’autre. Par exemple, il peut être intéressant, selon le module, de cibler le chef de ménage, la personne chargée de préparer les repas, le principal soutien économique du ménage ou encore les femmes en âge de procréer.

Concepts clés associés aux mesures

Pour collecter des données de qualité, il faut réfléchir soigneusement à ce que l’on cherche exactement à mesurer et au meilleur moyen d’obtenir ces informations. Les questions à poser pour collecter des données, même en apparence assez simples (la taille du ménage, par exemple), peuvent s’avérer étonnamment complexes.

Définitions

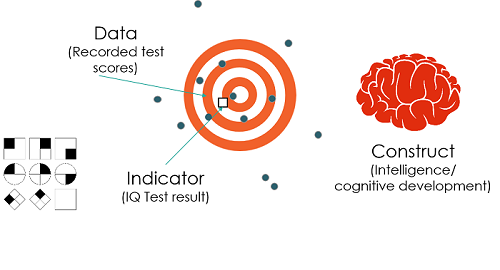

- Concept : Notion mesurable, qui peut être abstraite et avoir plusieurs définitions. Exemple : la compréhension, la criminalité ou encore le revenu.

- Indicateur : Outil permettant de mesurer et de suivre une étape majeure, une variable de résultat ou un concept donnés et de déterminer si nos hypothèses sont correctes. Exemple : les notes des élèves aux tests de mathématiques, les plaintes pour cambriolage ou le salaire journalier.

La figure ci-dessous illustre la relation entre les concepts, les indicateurs et les données

Des problèmes de mesure peuvent survenir à chacun de ces niveaux :

- Le concept peut avoir plusieurs facettes ou définitions valables, ce qui en fait une mauvaise mesure de la notion sous-jacente à laquelle on s’intéresse. Par exemple, le concept d’intelligence possède de nombreuses facettes différentes, comme l’intelligence émotionnelle, l’intelligence logique ou l’intelligence linguistique : si l’on ne sait pas exactement laquelle de ces facettes est la plus importante pour notre question de recherche, cela risque de poser problème.

- Les indicateurs utilisés pour mesurer le concept peuvent être imparfaits

- De nombreux facteurs peuvent influencer les réponses d’un individu à une enquête ou à un test (comme le niveau de distraction, la faim ou la maladie)

- Des erreurs humaines ou techniques peuvent entraîner la saisie de valeurs erronées

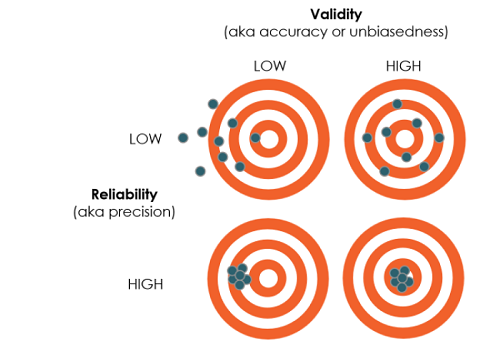

Les mesures ont pour objectif de recueillir des données présentant à la fois un haut degré de validité et de fiabilité.

- La validité : Mesurer exactement ce que l’on souhaite mesurer

- Question clé : Dans quelle mesure l’indicateur correspond-il à la variable de résultat ? En d’autres termes, s’agit-il d’une mesure non biaisée et précise de la variable de résultat ?

- Supposons par exemple que vous utilisiez le revenu pour mesurer le sentiment de sécurité financière des individus. Or, il est possible que cet indicateur ne caractérise pas parfaitement le sentiment de sécurité financière, et ce pour plusieurs raisons :

- Variations dans le temps : des revenus très irréguliers procurent probablement un sentiment de sécurité financière moins important que des revenus stables d’une valeur moyenne égale.

- Dépenses : c’est sans doute à l’épargne que le sentiment de sécurité financière est le plus étroitement lié. Or, les revenus ne contribuent à l’épargne que s’ils sont supérieurs aux dépenses.

- La fiabilité : Mesurer ce qui doit l’être avec précision

- Question clé : La mesure est-elle précise ou bruyante ?

- En guise d’exemple, voyons la différence entre le fait de mesurer le revenu journalier en demandant aux répondants d’indiquer leurs revenus de la veille et le fait de les interroger sur leurs revenus de la semaine écoulée :

- Dans le premier cas, les réponses seront plus variables que dans le second, du fait des fluctuations quotidiennes du revenu et des éventuels chocs journaliers ayant pu se produire la veille de l’enquête.

- Cependant, mesurer les revenus sur la semaine écoulée introduit un plus grand risque de biais de mémoire, ce qui peut provoquer des erreurs de mesure systématiques (par exemple si les répondants ont tendance à omettre certaines catégories de revenus dont il est difficile de se souvenir). Pour plus d’informations sur l’erreur de mesure systématique, voir ci-dessous.

Indicateurs indirects

Lorsque les principaux concepts étudiés (comme la criminalité ou les revenus) sont difficiles à mesurer, on peut avoir recours à des indicateurs indirects. Ce type d’indicateur doit :

- Être corrélé avec l’indicateur (plus la corrélation est forte, meilleur est l’indicateur indirect)

- Pouvoir évoluer de pair avec le concept. Par exemple, le sexe est un mauvais indicateur indirect du revenu, et ce malgré l’existence d’une corrélation, car il ne peut généralement pas être modifié dans le cadre d’une intervention.

Pour en savoir plus sur les indicateurs indirects les plus courants, y compris l’IPP (Indice de Probabilité de Pauvreté), consultez la ressource sur la conception des enquêtes.

Minimiser l’erreur de mesure

On parle d’erreur de mesure lorsque la réponse fournie par un répondant est différente de la vraie valeur, ou valeur réelle. Cette erreur peut être aléatoire ou systématique. Les effets des erreurs aléatoires s’annulent progressivement, ce qui n’est pas le cas des erreurs systématiques. Il est important de distinguer l’erreur de mesure, qui se produit au cours du processus de collecte des données, de l’erreur de validité, qui se produit lorsque les indicateurs ne correspondent pas exactement au concept étudié. Pour savoir comment concevoir une enquête de façon à minimiser l’erreur de mesure, voir la ressource sur la conception des enquêtes.

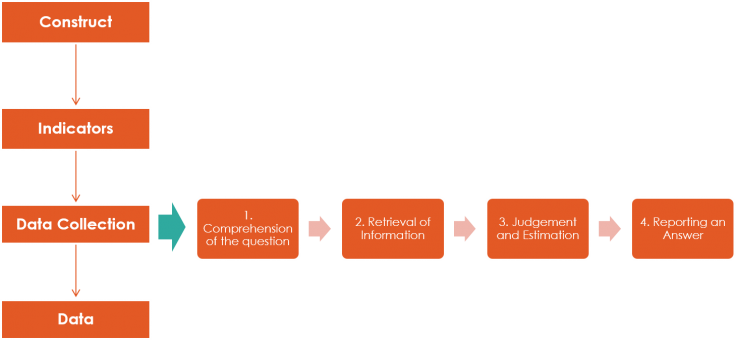

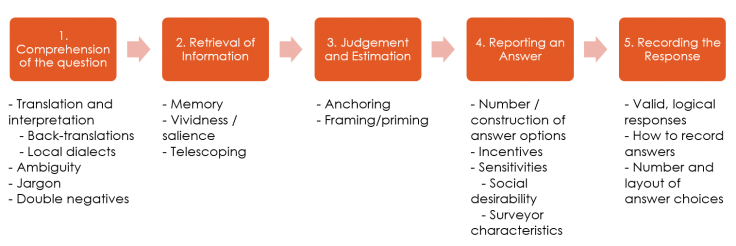

Le processus cognitif de réponse à une question

Avant de présenter les différentes sources d’erreur de mesure, considérons les étapes par lesquelles passe la personne interrogée lorsqu’elle répond à une question :

Par exemple, un répondant à qui l’on demande combien de fois il a mangé du riz ce mois-ci doit :

- Comprendre et interpréter la question.

- Réfléchir aux moments où il mange habituellement du riz.

- Additionner le nombre de jours que cela représente par semaine et par mois.

- Donner sa réponse (ou trouver la réponse adéquate parmi les options proposées).

Or, des biais peuvent se glisser à chacune de ces étapes. Par exemple :

- Il est possible que les répondants n’interprètent pas tous les termes « riz », « fois », « consommer » et « ce mois-ci » de la même manière. Par exemple, « ce mois-ci » fait-il référence aux 30 jours précédents ou au mois au cours duquel le répondant est interrogé (par exemple, le mois de juin) ?

- Les répondants peuvent aussi considérer que la question ne porte que sur la consommation de riz non transformé, et ne pas prendre en compte les produits à base de riz comme les nouilles, le lait, les crêpes, etc.

- Les répondants peuvent faire des erreurs de calcul, aggravées par les divergences d’interprétation mentionnées ci-dessus.

- Les répondants peuvent donner une estimation délibérément incorrecte (qui peut être le résultat d’un biais : par exemple, peut-être considèrent-ils que le riz n’est pas bon pour la santé, ce qui les pousse à prétendre que leur consommation est inférieure à ce qu’elle est réellement).

Types d’erreur de mesure

Il existe plusieurs sources d’erreur de mesure, qui peuvent être classées en trois catégories : 1) les problèmes liés aux questions, 2) les problèmes liés aux réponses et 3) les problèmes liés aux répondants.

Il existe plusieurs sources d’erreur de mesure, qui peuvent être classées en trois catégories : 1) les problèmes liés aux questions, 2) les problèmes liés aux réponses et 3) les problèmes liés aux répondants.

| Problème | Exemples | Conseils |

|---|---|---|

| L’imprécision : Les erreurs d’imprécision surviennent lorsque les répondants n’interprètent pas tous les questions de la même manière. | « Combien de fois avez-vous consommé du riz ce mois-ci ? »” Ici, il est possible que les répondants n’aient pas toutes la même interprétation des termes « riz », « fois », « consommer » et « ce mois-ci ». Par exemple, l’expression « ce mois-ci » fait-elle référence aux 30 jours précédents ou au mois au cours duquel le répondant est interrogé (par exemple le mois de juin) ? |

Examinez attentivement chaque mot de votre question en réfléchissant à ses différentes significations possibles, et définissez toute notion ambiguë. C’est particulièrement important pour les concepts abstraits, comme l’autonomisation, l’aversion au risque ou la confiance. |

| Les questions qui contiennent des négations : Ce type de question peut prêter à confusion et être mal interprété. | « Beaucoup de gens ne prennent régulièrement pas au moins un repas par semaine. Au cours de l’année passée, pendant combien de semaines cela n’a-t-il pas été le cas de votre famille ? » | Évitez autant que possible d’utiliser des négations. |

| Les questions doubles : Une question qui comporte plusieurs parties peut être source d’erreur. En effet, il n’est pas toujours évident de savoir à quelle partie de la question la personne interrogée est en train de répondre. | « Le gouvernement devrait-il mettre en place un système scolaire gratuit parce que l’école est trop chère dans notre communauté ? » | Évitez les structures de phrases alambiquées et décomposez les questions complexes en plusieurs parties. |

| Les présupposés : Si certaines questions reposent sur des présupposés concernant les répondants, cela peut compromettre la qualité des données collectées. | « Comment estimeriez-vous la qualité de votre café de ce matin ? » | Évitez autant que possible de faire des suppositions (ici, la question suppose que le répondant boit du café). Utilisez des questions filtres et des sauts de question chaque fois que c’est possible, et veillez à inclure une option « sans objet » pour toutes les questions où c’est nécessaire. |

| Les effets de cadrage (dans la question) : La façon dont les individus réagissent aux choix proposés dépend de la manière dont ceux-ci sont présentés.. | les individus risquent de donner des réponses très différentes aux deux questions suivantes : 1. Dans votre pays, il est illégal de frapper son enfant pour le punir. Avez-vous déjà frappé votre enfant pour le punir ? 2. Bon nombre de gens pensent que corriger physiquement leur enfant est un moyen efficace de lui apprendre à bien se conduire. Avez-vous déjà frappé votre enfant pour le punir ? |

Conseil : Essayez de formuler vos questions de la façon la plus neutre possible. |

| Les effets de cadrage (à l’échelle du questionnaire) : La façon dont les individus répondent à une question peut également varier en fonction des questions auxquelles ils ont déjà répondu. | Si une personne vient de répondre à une série de questions sur les enjeux en matière d’éducation dans son village, elle sera potentiellement plus encline à sélectionner l’éducation comme priorité politique absolue. | Faites attention au positionnement des questions et envisagez d’en faire varier l’ordre de façon aléatoire si vous craignez la présence d’un effet de cadrage. |

| Problème | Exemples | Conseils |

|---|---|---|

| L’exhaustivité : Les erreurs d’exhaustivité surviennent lorsque les répondants ne trouvent pas d’item de réponse correspondant à leur situation. | Toute question portant sur l’éducation doit inclure la réponse « sans instruction » | Veillez à ce que la liste des options de réponse soit complètement exhaustive et incluez les items « ne sait pas », « préfère ne pas répondre » et « autre (précisez) » chaque fois que c’est nécessaire. Un pilotage approfondi du questionnaire vous permettra également d’identifier les éventuelles options de réponse manquantes. |

| Le chevauchement des catégories : Si certaines catégories se recoupent, le répondant risque de pouvoir répondre à une même question de plusieurs façons. | Si les catégories vont de 0 à 5, de 5 à 10, de 10 à 15, etc., les répondants dont la réponse est 5 ont deux choix possibles. | Veillez à ce que toutes les catégories soient mutuellement exclusives. |

| Problèmes | Sous-Optimal | Préférable |

|---|---|---|

| Le biais de mémoire : La précision et l’exhaustivité des souvenirs varient d’une personne à l’autre. Pour remédier à ce problème, on peut notamment demander aux répondants de consigner les informations requises en temps réel. | « Qu’avez-vous mangé mardi soir il y a trois semaines ? » | « Je vous ai demandé de tenir un journal alimentaire et d’y noter tout ce que vous mangez chaque jour. Pouvez-vous me montrer ce que vous avez noté pour le mardi d’il y a trois semaines ? » |

| Le biais d’ancrage : Les individus ont tendance à trop se raccrocher à la première information qu’ils reçoivent (ou à la plus récente), et sont donc plus susceptibles de donner une réponse se rapprochant de cette information. Dans la mesure du possible, évitez donc d’inclure des « ancres » dans vos questions. | « La plupart des gens mangent 3 repas par jour. Selon vous, combien de repas par jour est-il normal de prendre ? » | « Le nombre de repas par jour varie d’une personne à l’autre. Selon vous, combien de repas par jour est-il normal de prendre ? » |

| La partialité : Les questions formulées de manière à suggérer une réponse particulière risquent de biaiser les répondants, surtout si l’on sous-entend une préférence pour une réponse plutôt qu’une autre. Formulez toutes les questions de la manière la plus neutre possible. | Le candidat X a un programme politique remarquable en matière de santé et d’éducation. Seriez-vous prêt à voter pour le candidat X ? | Seriez-vous prêt à voter pour le candidat X ? |

| Le biais de désirabilité sociale : Les répondants ont tendance à répondre aux questions de façon à se montrer sous un jour favorable, c’est-à-dire en mettant l’accent sur leurs points forts, en dissimulant leurs défauts ou en évitant la stigmatisation. Ils peuvent donc être réticents à avouer un comportement généralement mal vu. Essayez de poser vos questions de façon détournée et de faire en sorte que les questions délicates soient moins spécifiques, tout en veillant à protéger la confidentialité des répondants (et en le leur rappelant !). Vous trouverez davantage d’informations sur les questions sensibles dans la ressource sur la conception des enquêtes, ainsi que dans notre répertoire de ressources sur les mesures et la conception des enquêtes. | Dans votre pays, il est illégal de frapper son enfant pour le punir. Avez-vous déjà frappé votre enfant pour le punir ? | Tout le monde n’a pas la même approche pour apprendre la discipline à ses enfants. Avez-vous déjà frappé votre enfant pour le punir ? |

| Le biais de téléscopage : Les gens ont tendance à percevoir les événements récents comme plus anciens qu’ils ne le sont réellement (télescopage en amont), et les événements anciens comme plus récents (télescopage en aval), ce qui crée un risque de sur-déclaration ou de sous-déclaration. | Quels achats importants avez-vous effectués au cours de l’année passée ? |

Quels achats importants avez-vous effectués depuis le 20 janvier de l’année dernière ? N’incluez aucun achat effectué avant cette date. Notez que si vous avez posé la même question au début de l’enquête, il est encore plus efficace de formuler la question de la manière suivante : La dernière fois que je vous ai rendu visite, vous m’avez dit que vous aviez acheté X et Y au cours de l’année passée. Quels achats importants avez-vous effectués depuis ? |

| Le nombre et l’ordre des options de réponse : Les individus choisissent parfois la première réponse qui leur semble acceptable sans prendre la peine d’écouter les autres options de la liste, ou bien la toute dernière parce que c’est la plus récente et la plus facile à mémoriser. Pour éviter ce problème, on peut notamment limiter la longueur de la question et/ou le nombre d’options de réponse, et randomiser l’ordre des items dans les listes de réponses. | Toujours proposer les options de réponse dans le même ordre, ou laisser les personnes interrogées choisir une réponse avant d’avoir entendu toutes les options. | Randomiser l’ordre des options de réponse et insister pour que les répondants écoutent toute la liste avant de choisir une option ; ou bien demander aux enquêteurs de ne pas lire la liste des réponses possibles, mais les former à sélectionner l’option qui correspond le mieux à la réponse fournie par le répondant.. |

| Le biais de déclaration : Lorsque les réponses des répondants sont susceptibles de déterminer s’ils sont éligibles à un programme ou s’ils remplissent certains critères, ces derniers peuvent être tentés de faire de fausses déclarations. | Si un programme gouvernemental exige un certain niveau d’assiduité scolaire, les répondants risquent de gonfler le nombre d’heures de présence de leur enfant à l’école pour pouvoir en bénéficier. | Insister sur l’anonymat/la confidentialité, ou bien avoir recours à des indicateurs indirects ou à l’observation directe (en consultant les registres de présence des écoles, par exemple) plutôt que des réponses autodéclarées. |

| Le biais de réponse différentielle : Sous l’effet de l’intervention elle-même, le groupe de traitement (ou le groupe témoin) peut être plus susceptible de rapporter certains événements, de répondre à certaines questions ou d’apparaître dans les dossiers administratifs. | Une intervention a pour objectif de réduire l’incidence d’une maladie au sein d’une population donnée grâce à un traitement innovant. Cette intervention inclut notamment une campagne visant à encourager les gens à consulter un médecin. À la fin de l’étude, on a l’impression que l’incidence de la maladie a augmenté, alors que c’est en réalité la campagne visant à inciter les gens à se rendre à l’hôpital qui a été efficace, de sorte que le nombre de cas recensés a augmenté. | Assurez-vous que la capacité à mesurer un résultat donné n’est pas corrélée à l’assignation du traitement (par exemple, toute campagne visant à encourager les consultations à l’hôpital dans les villages de traitement doit également être menée dans les villages témoins) ; déterminez comment l’intervention est susceptible d’affecter le processus de réponse et choisissez des variables qui sont moins exposées aux biais ou plus facilement vérifiables. |

Données administratives

Les données administratives sont exposées aux mêmes sources de biais que les données d’enquête. Dans la mesure où le chercheur n’a pas de prise sur la phase de collecte et de traitement des données, un travail supplémentaire peut s’avérer nécessaire pour évaluer l’exactitude des données. Les types de biais que l’on rencontre le plus souvent dans les données administratives sont les suivants :

- Biais de déclaration : Comme pour la collecte de données primaires, les personnes interrogées peuvent avoir une incitation à sur-déclarer ou à sous-déclarer. Un individu peut par exemple sous-déclarer ses revenus pour pouvoir prétendre à un programme d’aide sociale, tandis qu’une institution administrative comme une école peut être tentée de sur-déclarer le taux d’assiduité de ses élèves pour répondre aux exigences officielles. Si les incitations à faire de fausses déclarations sont peut-être plus fortes que pour les données d’enquête, le fait qu’une grande partie des données administratives ne soient pas auto-déclarées contribue à limiter ce problème. Pour remédier au biais de déclaration :

- Identifiez le contexte dans lequel les données ont été collectées. Y avait-il des incitations à faire de fausses déclarations ?

- Choisissez des variables moins exposées aux biais (par exemple, une visite à l’hôpital plutôt que le montant d’une demande d’indemnisation auprès d’une compagnie d’assurance).

- Couverture différentielle : Outre les problèmes énumérés ci-dessus, les données administratives peuvent également présenter des différences de couverture entre le groupe de traitement et le groupe témoin : i) si la capacité à faire le lien entre les individus et leurs dossiers administratifs n’est pas la même dans les deux groupes et ii) si les membres des deux groupes n’ont pas la même probabilité de figurer dans les dossiers administratifs (par exemple si le nombre de victimes est mesuré à partir du nombre d’appels reçus pour signaler un acte criminel).

- On dit que les données administratives présentent un biais de sélection lorsqu’il n’existe de dossiers administratifs que pour les personnes ou les organisations qui sont en contact avec l’administration en question. Il peut notamment s’agir des bénéficiaires d’un programme, des candidats, des écoles et des hôpitaux partenaires, etc.

- Posez la question suivante : pour quelle raison l’organisme collecte-t-il ces données ?

- Posez la question suivante : pour quelle raison l’organisme collecte-t-il ces données ?

- Pour faire face aux différences de couverture et au biais de sélection :

- Identifiez clairement l’univers de données

- Quels individus figurent dans les données, quels individus en sont exclus, et pourquoi ?

- Identifiez les façons dont l’intervention est susceptible d’influer sur la déclaration des variables d’intérêt

- Déterminez dans quelle direction une sélection différentielle est susceptible de se produire et en quoi cela risque de biaiser l’effet estimé.

- Effectuez une enquête initiale en utilisant des identifiants pour pouvoir effectuer les mises en correspondance

- Vous aurez ainsi autant de chances de rattacher les individus traités et les individus témoins à leurs dossiers, et serez en mesure d’identifier toute différence de couverture.

- Identifiez clairement l’univers de données

Quel est le degré de gravité de l’erreur de mesure ?

Le degré de gravité de l’erreur de mesure dépend du type d’erreur et de son étendue, ainsi que de l’existence ou non d’une corrélation entre le biais et le traitement.

- Un biais qui n’est pas corrélé au traitement affecte de la même manière le groupe de traitement et le groupe témoin, et ne faussera donc pas l’estimation de la différence entre les deux groupes à la fin de l’étude.

- En revanche, si le biais est corrélé au traitement, c’est plus problématique : en effet, il affecte alors le groupe de traitement et le groupe témoin de manière différente, ce qui signifie qu’en moyenne, l’estimation de la différence entre les groupes à la fin de l’étude est biaisée. Les chercheurs risquent alors de tirer des conclusions erronées quant au signe et à l’ampleur de l’effet du traitement.

Secondary data resources

Administrative data resources:

- National-level administrative data can be found on the website of the ILO (labour data), World Bank (e.g., World Development Indicators including population data), UN (e.g., SDGs and trade) and national statistics authorities

- NASA/NOAA weather data

- J-PAL North America catalog of administrative datasets (US focus)

- Credit reporting agency data is available from Equifax, Experian, and TransUnion (US focus)

- The Research Data Assistance Center (ResDAC) provides information and assistance with applying for access to data from the Centers for Medicare and Medicaid Services

- Researchers have compiled an inventory of data sets used to study education

- The American Economic Association hosts resources enumerating sources and procedures for accessing US federal administrative data.

- Google’s Dataset Search tool that “enables users to find datasets stored across thousands of repositories on the Web, making these datasets universally accessible and useful.”

Non-administrative data:

- J-PAL/IPA Datahub for Field Experiments in Economics and Public Policy

- World Bank microdata catalogue

- IFPRI microdata catalogue

- The Guardian has compiled a list of existing datasets that may be of interest to international development researchers and practitioners.

Dernière mise à jour en février 2022.

These resources are a collaborative effort. If you notice a bug or have a suggestion for additional content, please fill out this form.

Ce document a été traduit de l’anglais par Marion Beaujard.

Nous tenons à remercier Liz Cao, Ben Morse et Katharina Kaeppel pour leurs commentaires précieux. Cette ressource a été traduite de l’anglais par Marion Beaujard.

Toute erreur est de notre fait

Additional Resources

The Questionnaire Design section of the World Bank’s DIME Wiki, including:

Grosh and Glewwe’s Designing Household Survey Questionnaires for Developing Countries: Lessons from 15 Years of the Living Standards Measurement Study

McKenzie’s Three New Papers Measuring Stuff that is Difficult to Measure and Using BDM and TIOLI to measure the demand for business training in Jamaica via The World Bank’s Development Impact Blog

J-PAL’s Practical Guide to Measuring Girls’ and Women’s Empowerment in Impact Evaluations

Bradburn, N. M., Sudman, S., & Wansink, B. (2004). Asking questions: The definitive guide to questionnaire design : for market research, political polls, and social and health questionnaires (Rev). San Francisco: Jossey-Bass.

Deaton, A., & Zaidi, S. (2002). Guidelines for constructing consumption aggregates for welfare analysis (No. 135). World Bank Publications.

Deaton, Angus S., Measuring Poverty (July 2004). Princeton Research Program in Development Studies Working Paper. Available at SSRN: https://ssrn.com/abstract=564001 or http://dx.doi.org/10.2139/ssrn.564001

Fowler, F. J. (op. 1995). Improving survey questions: Design and evaluation. Thousand Oaks [etc.]: Sage.

Marsden, P. V., & Wright, J. D. (2010). Handbook of survey research (2nd). Bingley, UK: Emerald.

Saris, W. E., & Gallhofer, I. N. (2007). Design, evaluation, and analysis of questionnaires for survey research. Wiley series in survey methodology. Hoboken, N.J: Wiley-Interscience.

Tourangeau, R., Rips, L. J., & Rasinski, K. A. (2000). The psychology of survey response. Cambridge, U.K, New York: Cambridge University Press.

References

Abay, Kibrom A., Leah EM Bevis, and Christopher B. Barrett. "Measurement Error Mechanisms Matter: Agricultural intensification with farmer misperceptions and misreporting." American Journal of Agricultural Economics (2019).

Bursztyn, L., M. Callen, B. Ferman, A. Hasanain, & A. Yuchtman. 2014. "A revealed preference approach to the elicitation of political attitudes: experimental evidence on anti-Americanism in Pakistan." NBER Working Paper No. 20153.

Feeney, Laura (with assistance from Sachsse, Clare). “Measurement." Lecture, Delivered in J-PAL North America 2019 Research Staff Training (J-PAL internal resource)

Glennerster, Rachel and Kudzai Takavarasha. 2013. Running Randomized Evaluations: A Practical Guide. Princeton University Press: Princeton, NJ.

Karlan, Dean. “3.2 Measuring Sensitive Topics." (J-PAL internal resource)

Sachsse, Clare. “Theory of Change and Outcomes Measurement [California Franchise Tax Board / CA FTB]”, Delivered in J-PAL’s May 2019 CA FTB training. (J-PAL internal resource)

Sadamand, Nomitha. “Measuring Better: What to measure, and How?” Lecture, Delivered in J-PAL South Asia’s 2019 Measurement and Survey Design Course. (J-PAL internal resource)

Sautmann, Anja. “Measurement.” Lecture, Delivered in J-PAL North America’s 2018 Evaluating Social Programs Exec Ed Training.

Sudman, S. & N. Bradburn. 1982. Asking Questions: a Practical Guide to Questionnaire Design. A Wiley Imprint.